Mit der Veröffentlichung der neuen System-on-Module Architektur Jetson™ AGX Orin, hat Hersteller NVIDIA® den Markt für Hardware-Lösungen ordentlich aufgewirbelt. Doch wie viel Einfluss wird die neue Plattform für skalierbares Embedded und Edge Computing in der Zukunft nehmen?

Künstliche Intelligenz wird in naher Zukunft überall um uns herum sein. Schon heute liefern vollständig autonome Drohnen Pakete an Endkunden oder prüfen Ackerflächen auf Schädlingsbefall und potenzielle Ernteerträge. Die Automatisierung industrieller Sektoren schreitet unaufhörlich voran und die Euphorie wird durch neue Technologien wie 5G und 6G nur noch weiter angeheizt.

Hardware-Hersteller und IT-Distributoren versuchen die Netzwerklast von ohnehin schon strapazierten Clouds zu reduzieren und nutzen dezentralisierte Edge Computing Lösungen in unmittelbarer Nähe zur Anwendung. Als weltweit führende Plattform für autonome Maschinen schöpft NVIDIA® Jetson™ das volle Potenzial von KI-gestützten mobilen Robotern, Drohnen, Netzwerk-Videorekordern oder optischen Inspektionen aus. Die Ankündigung der Jetson AGX Orin™ Module im September 2022, wirft daher die Frage auf, wie sich die neue Architektur auf zukünftige Hardware-Systeme auswirken wird.

KI-Leistung auf Serverniveau

Bei NVIDIA® Jetson™ handelt es sich um eine Serie von System-on-Modules (SOM) inklusive Prozessor, Grafikkarte, Speicher, Energiemanagement, High-Speed Schnittstellen und mehr. Die Systeme variieren dabei im Formfaktor, der Ausstattung sowie der Energieeffizienz, um verschiedene Branchen abdecken zu können. Die neu vorgestellten Jetson Orin™ Module bieten in der höchsten Modellklasse bis zu 275 TOPS (Tera Operations per Second), was dem 8-fachen KI-Leistungspotenzial der Xavier™ Generation entspricht.

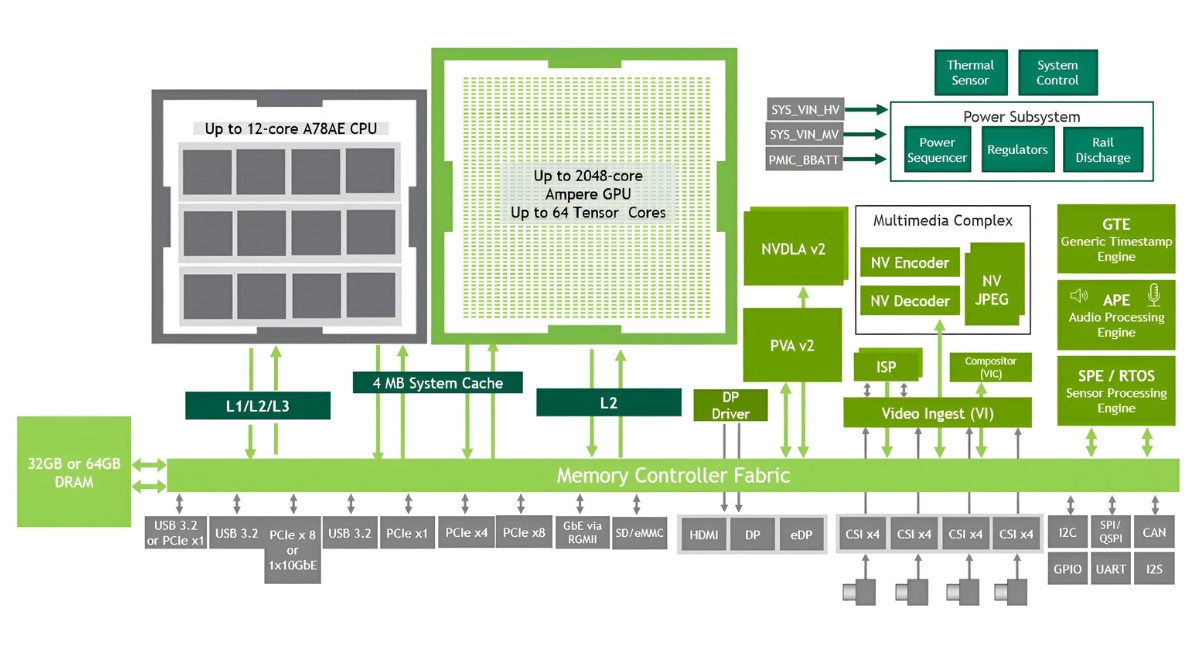

Die integrierte Ampere GPU besteht aus 2 Grafik-Prozessor-Clustern (GPC), bis zu 8 Textur-Prozessor-Clustern (TPC) sowie bis zu 16 Streaming-Multiprozessoren (SM) mit 192KB an L1-Cache und 4MB L2 Cache. Zusätzlich werden 128 CUDA-Kerne pro SM unterstützt, wodurch die 64GB-Version des Orin™ Moduls insgesamt 2048 CUDA-Kerne und 64 Tensor-Kerne zu bieten hat. Der NVIDIA® Deep Learning Accelerator (DLA) ist ein Festfunktionsbeschleuniger, der für Deep-Learning-Operationen optimiert ist. Er ist für die vollständige Hardware-Beschleunigung der faltungsneuronalen Netzinferenz geschaffen worden. Der Orin™ SoC bietet Unterstützung für die nächste Generation von NVDLA 2.0 mit der neunfachen Leistung von NVDLA 1.0 sowie einer energieeffizienteren Architektur.

Die GPU- und DLA-Optimierungen heben die KI-Leistung von Orin™ auf Serverniveau. Unterdessen steigen auch die Anforderungen an die Rechenleistung um Größenordnungen für Funktionen wie Multi-Sensor-Wahrnehmung, Kartierung und Lokalisierung, Planung und Steuerung sowie Situationsbewusstsein und Sicherheit. Insbesondere die Robotik und andere Edge-KI-Anwendungen erfordern immer mehr Ressourcen für Computer Vision und konversationelle KI. Das Jetson AGX Orin™ Modul liefert die bis zu 3,3-fache Leistung von Jetson AGX Xavier™ bei realen KI-Anwendungen (gemessen in Inferenzen pro Sekunde), wie vortrainierte Modelle bereits zeigen. Ausgehend davon ließe sich diese Leistung mit zukünftigen Software-Updates um das beinah 5-fache steigern.

Infografik NVIDIA® Jetson™ AGX Orin

Anwendungsfälle und Hardware in der Pipeline

Mit Orin™ Entwickler-Kits können Unternehmen komplexe und zukunftsgerichtete KI-Anwendungen an der Edge realisieren. Dazu zählen Anwendungsbereiche wie Industrial IoT, Logistik und Transportwesen, Agrarwirtschaft oder das Gesundheitswesen. Durch die Kompatibilität von Cloud-nativen Workflows und KI-Software, die schon auf Vorgänger-Plattformen verwendet wurde, ermöglichen die neuen Module Unternehmen zusätzliche Performance und Energieeffizienz, um mobile Roboter für verschiedene Alltagsaufgaben entwickeln zu können. Autonome Maschinen sortieren schon heute Waren in Logistikhallen oder betreuen selbstständig Kunden im Einzel- oder Großhandel. Auch automatisierte Zutrittskontrollen für Gefahrenbereiche, in denen Mitarbeiter nur mit Helm und Sicherheitsweste eintreten dürfen, werden durch kompakte Jetson™ Hardware in Echtzeit ermöglicht.

Die Nachfrage nach den neuen Modulen ist vorhanden und wird, in Anbetracht des Preis-Leistungsverhältnisses, weiter steigen. Hersteller und Systemhäuser haben unlängst einen straffen Zeitplan geschaffen und in den nächsten Monaten und Jahren werden Embedded PCs und GPU-Computer auf Basis von Orin™ SoCs zur Marktreife gelangen. Hardware-Hersteller für frei konfigurierbare Edge Intelligence Lösungen wie AI-BLOX berichteten bereits seit Dezember 2022 über neuartige Prozessormodule mit Jetson AGX Orin™. Weitere Modelle mit Orin NX™ und Orin Nano™ sollen zeitnah folgen. Das NASDAQ-Unternehmen One Stop Systems plant für 2023 in Zusammenarbeit mit dem Systemhaus BRESSNER Technology ein kompaktes Dual-Orin System in einem Ruggedized-Chassis. Die High-Performance-Computing-Experten nutzen Synergien, um den europäischen Markt für industrielle Supercomputer zu erschließen.

Die Veröffentlichung der neuen NVIDIA® Jetson™ AGX Orin Plattform wird zweifelsfrei großen Einfluss auf die Zukunft des Edge Computing haben. Die Kombination aus Leistungsfähigkeit und Skalierbarkeit entspricht den Anforderungen, die industrielle Betriebe an moderne KI-Anwendungen stellen: Klassifizierung, Objekterkennung, Text-to-Speech, Sprachübersetzung, Empfehlungsdienste, Stimmungsanalyse und vieles mehr. Künstliche Intelligenz wird in naher Zukunft immer mehr Teil unseres Alltags sein und die Jetson AGX Orin™ Plattform wird eine Schlüsselrolle in dieser Entwicklung spielen.