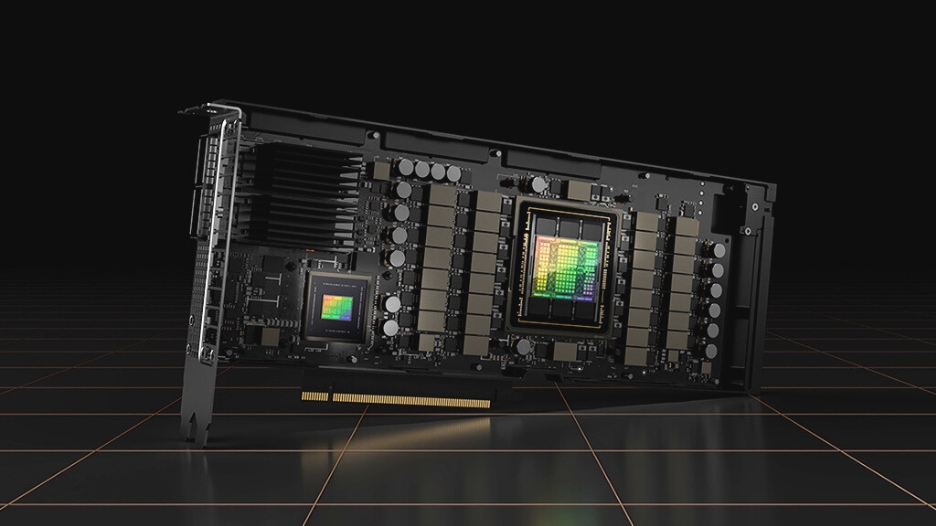

Wir bei BRESSNER Technology und der Muttergesellschaft One Stop Systems Inc. (OSS) sind stolz darauf, hochleistungsfähige Lösungen anbieten zu können, die unsere Kunden bei der Bewältigung der anspruchsvollsten Rechenaufgaben unterstützen. Aus diesem Grund freuen wir uns, Ihnen den NVIDIA® H100 Tensor Core Grafikprozessor vorstellen zu können, einen unglaublich leistungsstarken Grafikprozessor, der für eine Vielzahl von Anwendungsfällen eine außergewöhnliche Leistung bietet.

Der H100 basiert auf der hochmodernen NVIDIA® Hopper GPU-Architektur und ist damit die erste Wahl für Anwendungen, die blitzschnelle Datenverarbeitung erfordern. Mit Tensor Cores der vierten Generation liefert der H100 bis zu 5x schnellere KI-Trainings und bis zu 30x schnellere KI-Inferenzen bei großen Sprachmodellen im Vergleich zur vorherigen A100-Generation. Damit ist er einer der fortschrittlichsten Grafikprozessoren auf dem Markt und die perfekte Ergänzung für unsere PCIe-Erweiterungen und GPU-Server.

In diesem Blogbeitrag werden wir die Architektur und Hierarchie des H100 näher beleuchten und einige der spannenden Anwendungsfälle beleuchten, für die dieser Grafikprozessor besonders geeignet ist. Ganz gleich, ob Sie mit komplexen KI-Modellen arbeiten oder High Performance Computing für die Forschung benötigen – die H100 GPU ist eine bahnbrechende Lösung, mit der Sie Ihre Ziele schneller und effizienter als je zuvor erreichen können.

Die H100-GPU-Hierarchie und Architektur

Die rasanten Fortschritte in der GPU-Rechenarchitektur haben zu einer bedeutenden Entwicklung in der neuesten H100-GPU-Hierarchie von NVIDIA geführt. Während das CUDA Programmiermodell jahrelang auf Grids und Thread-Blöcken basierte, um Programmlokalität zu erreichen, ist der herkömmliche Thread-Block-Ansatz mit der wachsenden Komplexität der Programme und dem Aufkommen von GPUs mit über 100 Streaming-Multiprozessoren (SMs) unzureichend geworden.

Um dieses Problem zu lösen, hat NVIDIA® mit der H100 GPU einen innovativen Thread Block Cluster Architektur eingeführt. Diese Architektur bietet ein höheres Maß an Kontrolle über die Lokalität und ermöglicht eine höhere Granularität als ein einzelner Thread-Block auf einem einzelnen SM. Mit Thread Block Clusters wurde das CUDA Programmiermodell auf eine neue Ebene erweitert, indem Threads, Thread-Blöcke, Thread-Block-Cluster und Grids zur physikalischen Programmierhierarchie des Grafikprozessors hinzugefügt wurden.

Was genau ist also ein Thread-Block-Cluster? Vereinfacht dargestellt, handelt es sich um eine Sammlung von Thread-Blöcken, die gleichzeitig auf einer Gruppe von SMs geplant werden. Diese neue Architektur zielt darauf ab, die effektive Zusammenarbeit von Threads über mehrere SMs zu erleichtern, was zu einer verbesserten Performance und einer höheren Ausführungseffizienz führt.

Der NVIDIA® H100 Grafikprozessor verfügt über zahlreiche Innovationen, die ihn zu einem Kraftpaket für die Anwendungen in den Bereichen AI Transportables und High-Performance-Computing machen. Der H100 basiert auf der neuen Hopper-GPU-Architektur und ist mit innovativen Funktionen ausgestattet, die ihn leistungsfähiger, effizienter und flexibler machen als alle anderen GPUs zuvor.

Eine der wichtigsten Neuerungen des H100 sind seine Tensor Cores der vierten Generation, die Matrixberechnungen schneller und effizienter als je zuvor durchführen. Dadurch kann die H100 ein breiteres Spektrum an KI– und HPC-Aufgaben mühelos bewältigen und ist damit die ideale Wahl für unsere Kunden, die von ihrem Grafikprozessor die maximale Leistungsfähigkeit verlangen.

Anwendungsfälle für die H100-GPU

Der NVIDIA® H100 wurde für High Performance Computing entwickelt und eignet sich für eine breite Palette von Anwendungsfällen. Einige der häufigsten Anwendungsfälle für den H100 sind:

- Deep Learning: Der NVIDIA® H100 ist dank seiner leistungsstarken Tensor Cores eine ideale Lösung für Deep-Learning-Anwendungen. Der Grafikprozessor kann riesige Datensätze verarbeiten und komplexe Berechnungen durchführen, die für das Training tiefer neuronaler Netze erforderlich sind.

- High Performance Computing: Aufgrund seiner hohen Speicherbandbreite und leistungsstarken Verarbeitungsfunktionen eignet sich der H100 auch für Hochleistungsberechnungen, wie z. B. für wissenschaftliche Simulationen, Wettervorhersagen und Finanzmodellierung.

- KI-Inferenz: Der NVIDIA® H100 kann auch für KI-Inferenz-Workloads, wie Bild- und Spracherkennung, eingesetzt werden. Die leistungsstarken Tensor Cores des Grafikprozessors ermöglichen die schnelle Verarbeitung großer Datenmengen und machen ihn zu einer hervorragenden Wahl für Echtzeit-Inferenzanwendungen.

- Computer Vision: Darüber hinaus kann die H100 für Computer Vision Anwendungen, wie z.B. Objekterkennung und Bildsegmentierung, eingesetzt werden. Die Tensor-Cores des Grafikprozessors ermöglichen die schnelle Verarbeitung großer Mengen von Bilddaten.

- Computational Biology: Die H100 eignet sich auch für computergestützte Biologieanwendungen wie Genomsequenzierung und Proteinfaltungssimulationen. Die leistungsstarken DPX-Befehlsverarbeitungsfunktionen und die hohe Speicherbandbreite des Grafikprozessors machen ihn für diese Art von Anwendungen besonders geeignet.

Fazit: NVIDIA® H100 setzt neue Maßstäbe

Der H100 ist ein High-End-Grafikprozessor mit zahlreichen Innovationen, die ihn zur idealen Wahl für die Anwendungen unserer Kunden machen. Mit seiner fortschrittlichen Architektur und den Tensor Cores der vierten Generation ist der H100 einer der leistungsstärksten, programmierbarsten und energieeffizientesten Grafikprozessoren, die es Anwendern und Anwendungen ermöglicht, alle Recheneinheiten ihres H100-GPUs zu jeder Zeit voll auszulasten.

Wir sind der Meinung, dass der H100 eine ausgezeichnete Wahl für Unternehmen ist, die hochleistungsfähige Computing-Funktionen benötigen. Seine Verarbeitungsleistung und Speicherbandbreite machen ihn ideal für die Bewältigung der anspruchsvollsten Workloads, und seine Fähigkeit, blitzschnelle KI-Trainings und Inferenzbeschleunigungen bei großen Sprachmodellen zu liefern, machen ihn zu einer bahnbrechenden Lösung für Unternehmen, die mit komplexen KI-Modellen arbeiten.